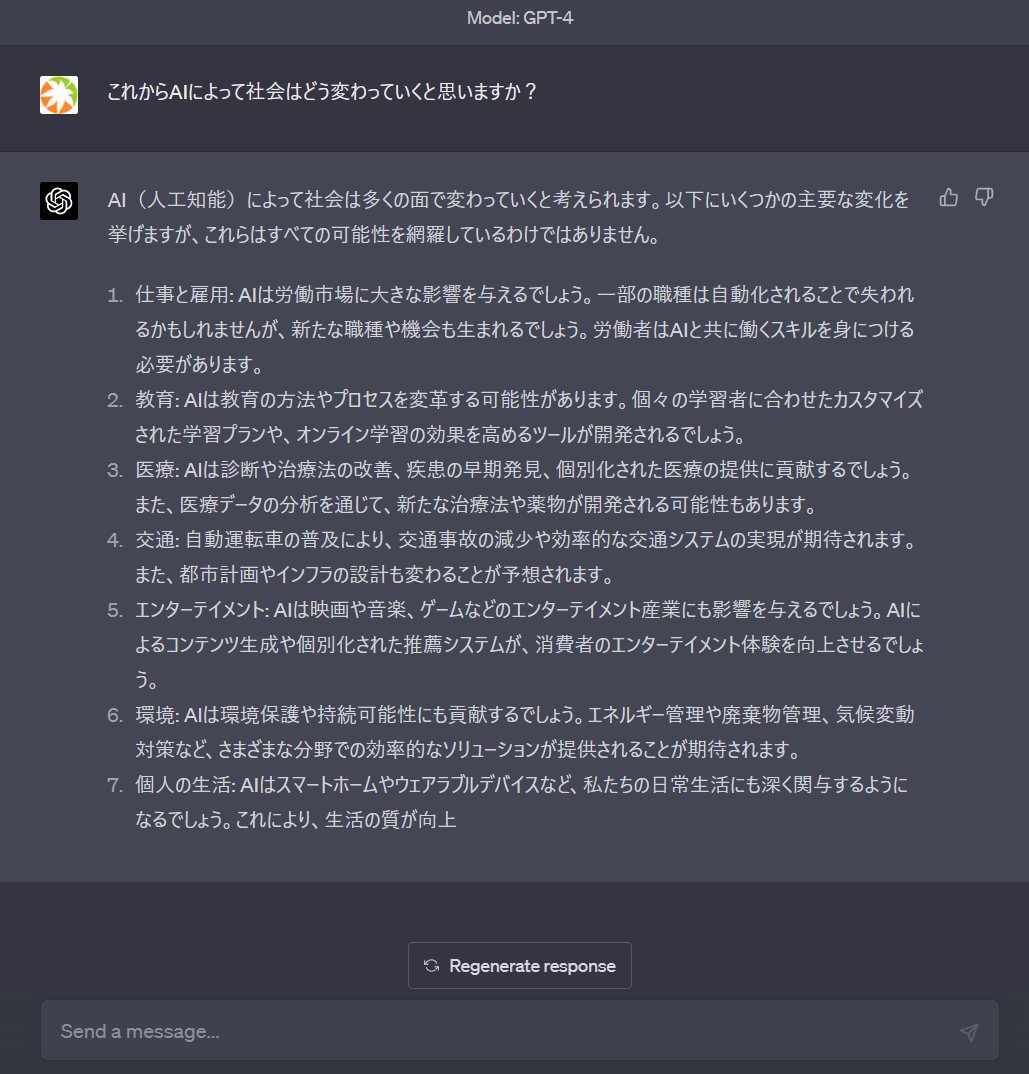

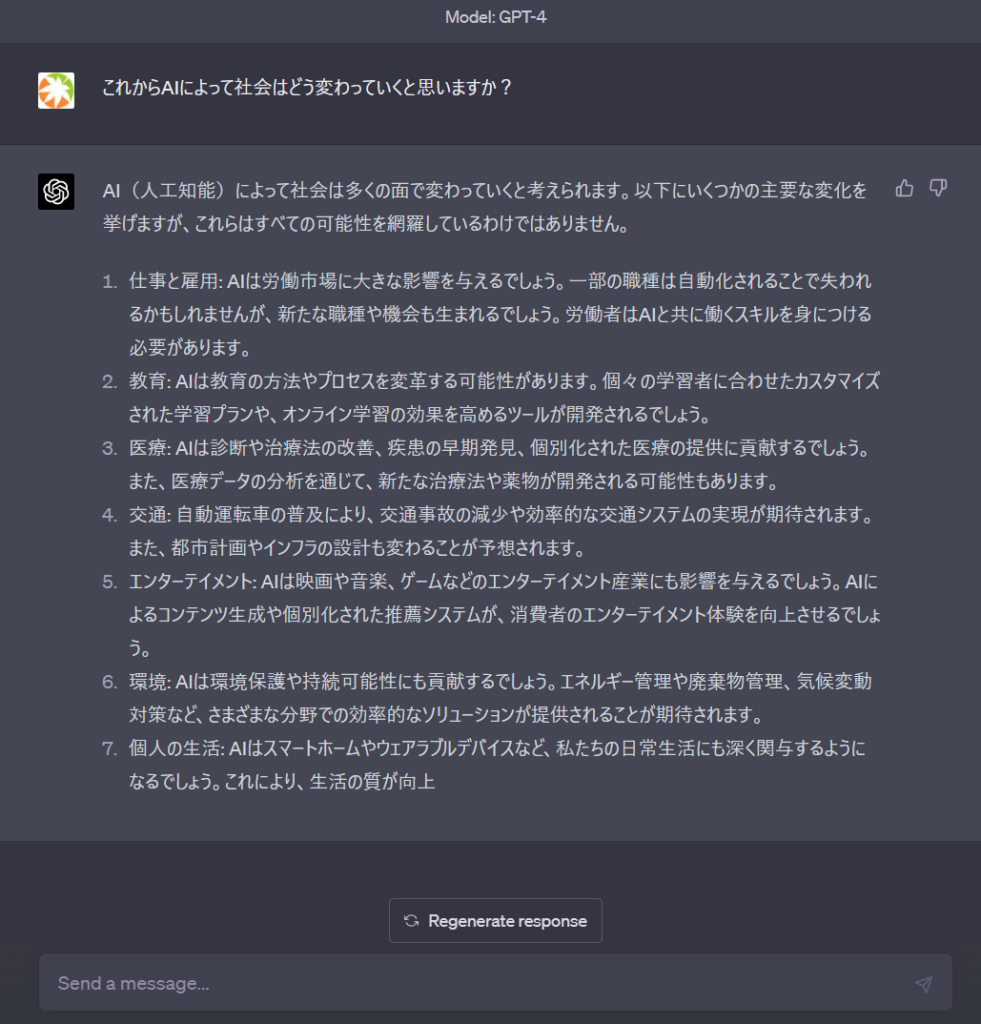

先日、GPT-4がリリースされ、ChatGPT Plusで利用できるようになりました。いろいろと対話を重ねているところですが、GPT-3.5よりも回答の精度が格段に向上しており、根拠が存在しないことは知らないと答えるなど、無知の知も獲得しつつあるように感じます。

GPTをはじめとする大規模言語モデルの躍進は、2017年にGoogle が発表した以下のTransformerの論文が起点となっています。

Vaswani, Ashish, et al. “Attention is all you need.” Advances in neural information processing systems 30 (2017).

https://arxiv.org/pdf/1706.03762.pdf

この論文の発想はとてもシンプルで、これまでディープラーニングで主流だったRNNやCNNを使わずに、Attention のみを用いたモデル、Transformerを使用することで、ベクトル化した単語の計算を並列で行えるようにし、精度と汎用性を飛躍的に向上させることができるというものです。

ただこのシンプルなモデルで、なぜAIがこれだけ高度な言語能力を持ち、また絵を描いたり、音楽を作ったりできるのかが、いまだに理解できておりません。まだデモでしか確認できていませんが、GPT-4では与えた画像を認識し、論理的に説明できるようになっています。

OpenAI社 のサムアルトマンのプレゼンテーションは、かつてのスティーブジョブズの iPhone の発表のように心躍るものではありますが、同時にある種の不安を感じることもあります。

当初、人間の仕事は単純労働からAIに置き換えられると言われていましたが、このままだと専門職やホワイトカラーから先にAIに置き換えられていくかもしれません。また、当分先だと思っていたAGI(汎用人工知能)が、このペースでいくと近い将来、本当に実現できてしまうのかもしれません。もしAGIが実現できたら、人間より遥かに早くAIが自律的に進化していく可能性が高く、人類にとっては宇宙人に遭遇するような体験になるかもしれません。

現時点でGPT-4のAPI は公開されておりませんでした。以下のサイトに登録することでAPIが利用できるようになった際に通知を受けられるようです。早速登録してみました。

GPT-4 API waitlist

https://openai.com/waitlist/gpt-4-api